Gouvernance et culture Data, mêmes objectifs, même combat

Nos articles précédents ont mis en lumière la capacité de la gouvernance de données à répondre avec efficacité à certains cas d’usage, ainsi que son rôle pour aider les entreprises à prendre conscience du caractère essentiel du partage de l’information, dans l’économie moderne.

Depuis peu, émerge la notion de « culture Data ». En quoi consiste-t-elle et qu’implique-t-elle concrètement ? Peut-elle répondre à ce besoin de partage de l’information ?

Dans cet article, nous vous apportons des réponses claires, et vous démontrons dans quelle mesure la culture Data interagit de manière optimale avec la gouvernance des données.

Définition

La « culture Data » est un terme récent, rendu populaire par la réussite des GAFA. Dès leur création, ces entreprises ont basé leur business model sur l’exploitation des données, en développant une approche innovante d’appropriation, d’analyse et d’utilisation de volumes de données parfois gigantesques. Avec la prise de conscience de la valeur des données, cette tendance s’est progressivement répandue, pour finalement s’affirmer comme une culture d’entreprise à part entière, au sein de laquelle les données servent non seulement à créer de la connaissance, mais surtout à aiguiller la stratégie de l’entreprise. La « culture Data » était née.

Ni GAFA, ni start-up, et pourtant …

Dans les conférences sur la digitalisation, on se réfère souvent à l’histoire de Kodak, le géant de la fabrication et du traitement des pellicules photo argentiques. N’ayant pas su prendre le virage du numérique, l’entreprise a, en quelques années, quasiment disparu. Mais cet échec relève plus d’un changement profond des habitudes de consommation auquel Kodak n’a pas cru, que d’un problème inhérent à la transformation numérique de ses propres processus. L’exemple démontre à quel point une entreprise peut péricliter rapidement si elle ne fait pas évoluer son modèle économique. Rien de plus naturel.

Toutefois, les entreprises ne sont pas toutes confrontées à une disruption. L’enjeu pour la majorité d’entre elles n’est pas de se réinventer. Il s’agit plus classiquement de s’adapter au mieux et le plus rapidement possible aux nouvelles habitudes et exigences de leurs clients. La réponse réside clairement aujourd’hui dans la digitalisation des services.

Les changements pourraient paraître moins radicaux d’un point de vue stratégique, mais leur impact ne doit pas être négligé. La question consiste à comprendre comment passer d’un fonctionnement en silo, centré sur la satisfaction d’un objectif métier, à une circulation fluide de l’information pour répondre à des besoins multiples ?

Si une partie de la réponse relève de la technique, celle-ci ne résout pas tout. Le risque est de créer de nouveaux silos, avec des nouveaux métiers spécialisés dans le traitement des données, isolés de leurs collègues producteurs de données. Pour une réussite pérenne, l’entreprise doit prendre conscience de l’importance de la destination des données produites et des nouvelles utilisations potentielles, créatrices de connaissances et donc de valeur.

Ainsi, la Culture Data symbolise la prise de conscience généralisée et collective des acteurs de l’entreprise quant à l’importance et la valeur des données. La donnée produite par un service doit être accessible par tous, pour favoriser d’autres utilisations. Il s’agit, en réalité, d’étendre les notions de travail collaboratif à tout ce qui concerne les données. La culture Data rejoint ici de nombreux principes portés par la gouvernance des données.

Partager ses connaissances

D’innombrables projets de digitalisation foisonnent dans les entreprises aujourd’hui. Mais ils sont souvent freinés par des obstacles internes, principalement liés à la résistance au changement et à une faible compréhension des objectifs. Vos collaborateurs ont besoin de connaître les impacts que cette digitalisation aura sur leur rôle, ainsi que les conséquences sur leur travail quotidien.

Au même titre que la gouvernance des données, la culture Data est un ensemble de bonnes pratiques visant à étayer la cohérence des actions menées autour de la donnée. Chaque producteur et chaque utilisateur potentiel de données a besoin de s’approprier un nouveau mode de fonctionnement. En plus de son travail habituel, il doit comprendre où il se situe dans la chaîne de traitement de l’information et dans quelle mesure telle ou telle information peut être exploitée par d’autres services.

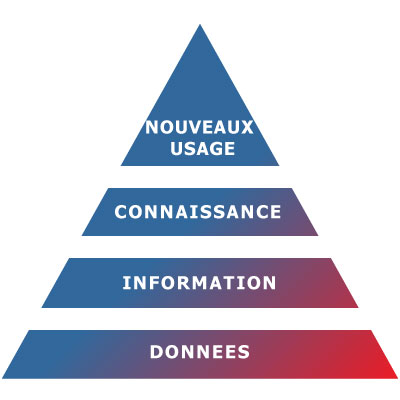

En schématisant, voici l’objectif simplifié du développement d’une culture Data :

Les données sont à la source de l’information. En impliquant fortement les collaborateurs, les informations sont transformées en connaissances pouvant mener à l’émergence de nouveaux usages.

Les spécialistes de l’IT savent qu’une architecture en silo est une vision de l’entreprise où chaque département agit de manière autonome pour satisfaire ses propres besoins et contraintes. La connaissance s’est calquée sur le même schéma dans les modèles d’entreprise standards jusqu’à former des silos informationnels. Ce sont des niches de savoir associées à un département, un métier, ou un domaine d’activité au sein de votre organisation.

Partager la connaissance représente un atout encore sous-estimé qui implique de changer de paradigme. Cette prise de conscience est impérative pour favoriser l’accessibilité, l’homogénéité et la cohérence des données. Développer une culture Data signifie en finir avec les architectures « silotées » et mettre la donnée au centre des échanges. Fini le travail isolé. Une donnée existe, elle a potentiellement de la valeur pour d’autres, et quand je la produis, au-delà de la réalisation de ma tâche, je me soucis de son utilisabilité pour les autres (qualité, complétude, fraîcheur, etc.). La collaboration et le partage de connaissances participent activement à la création de cette culture.

« La connaissance est la seule ressource, qui une fois partagée, s’en retrouve multipliée » Idriss Aberkane, « L’âge de la connaissance ».

Comment développer sa « culture Data » ?

Développer une culture Data n’est pas naturel pour des entreprises qui reposent sur des modes organisationnels traditionnels, souvent éloignés de ceux des start-ups. Il s’agit donc de la développer progressivement et de façon non invasive, en établissant prioritairement un plan de communication pour faciliter la prise de conscience et la sensibilisation. L’élaboration de plans de formation permettra en outre de partager un langage commun, tout en alertant les collaborateurs sur les conséquences d’un partage d’informations erronées.

L’utilisation de tous les supports de communication disponibles dans l’entreprise facilite bien sûr la circulation de l’information. Parmi eux, l’accès au catalogue des données doit être universel. Chacun doit pouvoir se situer dans la chaîne de traitement d’une information. C’est le meilleur moyen de prendre conscience de son importance et d’échanger avec ses collègues. Des actions de formation à l’utilisation du catalogue devront donc être menées régulièrement. (Dans notre prochain article, nous vous expliquerons dans quelle mesure un catalogue de données aide les organisations à gouverner leurs données et à développer une culture Data).

Les changements d’habitudes réclament du temps. Ils doivent être accompagnés pour s’inscrire dans la durée. Créer des espaces de partage en dehors des silos métiers permet d’optimiser la transversalité. La culture Data prend alors tout son sens et s’ancre dans la durée.

Tout changement peut poser problème à chacun de nous. Changer nous engage à sortir de notre zone de confort, ce que peu de personnes acceptent volontiers. Nous devons être convaincus que l’effort à fournir va nous apporter des bénéfices. Les leviers utilisés doivent donc être pertinents et s’adapter à la culture de l’entreprise. Ainsi, les agents d’une administration ont pour mission d’apporter un service aux citoyens. L’implication dont ils font preuve dans l’accomplissement de cette tâche est souvent admirable, et la seule idée qu’une erreur dans la communication d’information pourrait ternir l’image du service public est un excellent levier d’amélioration des pratiques.

Si elle n’est pas organisée, la mise en place d’une culture Data peut, de surcroît, aboutir à des situations erratiques autour de la donnée, notamment en favorisant des usages non conformes, mais aussi la transmission d’informations à des personnes non autorisées. Un cadre est nécessaire pour s’assurer que cette nouvelle culture Data ne soit pas un moteur de confusion pour l’entreprise.

Pas de culture Data sans gouvernance

La gouvernance de données et le développement d’une culture Data sont deux notions étroitement liées. Aborder le développement d’une stratégie Data et d’une culture associée est un projet dont la réussite est illusoire sans la mise en place de règles formelles. De la même manière, la gouvernance de données ne saurait exister sans le développement de politique du changement et d’éducation des parties prenantes.

Toutes les actions doivent être soutenues par une organisation pérenne. La gouvernance des données joue un rôle prépondérant, puisque c’est elle qui définit et met en œuvre les règles de fonctionnement liées aux données. Elle assure en outre un énorme travail de collecte et d’investigation, mais aussi d’organisation et de définition des responsabilités.

Grâce à la vision globale qu’elle procure, la gouvernance de données permet de réaliser des actions de communication interne selon la maturité de la culture Data et le niveau de déploiement d’actions de gouvernance (outils et mécanismes). La culture Data devient, en retour, un vecteur de communication pour la gouvernance.

Par définition, la gouvernance des données a un rôle d’arbitre et favorise le développement d’une culture autour de la donnée qui sera un vecteur de communication. Il est important de comprendre que l’interdépendance de ces deux disciplines est réelle et qu’il serait aberrant de les aborder séparément.

Optimiser la qualité des données grâce à la Gouvernance

Dans notre précédent article, vous avez découvert pourquoi la gouvernance de donnée doit être actionnée en amont d’un projet de mise en conformité. Ici, notre propos est de mettre en relief les synergies entre une gouvernance efficace et la maîtrise de la qualité des données, afin d’aider les entreprises conscientes de l’importance du sujet, mais ne disposant pas des méthodes adaptées, à en matérialiser les bénéfices.

La qualité des données est souvent synonyme d’actions correctives, visant uniquement à en accroître l’utilisabilité, dans un contexte métier limité. A travers des exemples concrets, nous allons illustrer dans quelle mesure les problématiques de qualité de données peuvent être prises en charge avec plus d’efficacité, en s’appuyant sur des processus de gouvernance des données.

Qu’est-ce que la qualité des données ?

La qualité des données est un ensemble de critères visant à identifier la capacité d’une donnée à restituer de l’information, en se conformant aux usages prévus.

La qualité d’une donnée est donc évaluée selon les dimensions suivantes :

• La disponibilité : L’information existe-elle ?

• La conformité : L’information peut-elle être exploitée dans cet état ? Respecte-t-elle les règles métier qui la définissent ? (ex. : une adresse mail sans @ )

• La véracité : L’information est-elle vraie et vérifiée ?

• La cohérence : L’information est-elle toujours structurée de la même manière ?

• Temporalité : L’information est-elle actualisée ? Quelle est sa fraîcheur ?

Certaines dimensions de la qualité de données sont relatives au contexte dans lequel elles sont évaluées .

La qualité des données étant une discipline tangible et pragmatique, il est par conséquent facile d’obtenir des indicateurs chiffrés et explicites qui en facilitent la gestion.

Dans un contexte de gouvernance, la qualité est sous-jacente à une notion plus globale : l’utilisabilité. Celle-ci traduit la capacité d’une donnée à être exploitée facilement et efficacement par un consommateur qui peut être une personne, un service ou un système. Elle est, par conséquent, adaptée à son usage.

Quelle sont les causes d’une mauvaise qualité de données ?

L’erreur humaine

Beaucoup de données sont générées par l’intermédiaire d’un opérateur humain. Par nature, nous devons donc nous attendre à traiter des erreurs involontaires.

En outre, la saisie intervient le plus souvent dans l’exécution d’une opération métier, avec un objectif précis qui n’est pas de générer de la donnée. Or, pour un opérateur, les interfaces applicatives ne sont qu’un moyen. L’accomplissement de cet objectif étant prioritaire, tout blocage doit être résolu immédiatement ou contourné. On se retrouve donc fréquemment avec des dossiers métier complets, mais dont les données ne sont pas toujours structurées efficacement, d’un point de vue technique. Ainsi, l’opérateur n’est pas toujours attentif à la qualité des informations qu’il transmet, mais plutôt à la nécessité d’accomplir la tâche qui lui est attribuée.

Se pose donc la question de la conscience de la notion de qualité, et de la maîtrise de ses impacts globaux. Information et pédagogie sont ici essentielles.

L’absence d’outils adaptés

Au-delà de la dimension humaine, il est nécessaire de fournir aux différents intervenants des outils ou applications facilitant la création de donnée et respectant les critères d’utilisabilité. Grâce à des processus clairement définis et couvrant tout le spectre de l’activité, le risque d’erreur diminue.

Une responsabilité mal définie

En partant du postulat que la qualité des données est généralement perçue comme une discipline corrective, il n’est pas rare qu’elle relève de la seule responsabilité de l’IT qui doit alors mesurer les impacts métiers et prendre des mesures d’évaluation, mais sans pouvoir intervenir à la source pour corriger une donnée erronée. Elle peut également être traitée périodiquement par des spécialistes métiers, avant l’exécution de tâches plus globales qui exigent des vérifications en amont afin d’obtenir le résultat escompté, mais avec les mêmes difficultés sur les actions de correction.

Dans ces situations, la problématique n’est pas abordée de manière optimale. La conscience de l’utilisabilité est perdue par le producteur des données, les correctifs appliqués sont beaucoup moins efficaces, car le nombre de cas à traiter est difficile à évaluer et ne cesse d’évoluer, et plus personne n’est réellement responsable d’une donnée. Se pose donc la question des rôles et des responsabilités

La gouvernance au service de l’utilisabilité

La connaissance de l’écosystème, premier moteur de qualité

Un opérateur métier saisit un ensemble de données concernant des personnes. Ces informations sont de différents types (texte, date, …), et l’application utilisée ne propose qu’un nombre limité de contrôles de format ou d’obligations. Les personnes du service n’ont pas de connaissances spécifiques en matière d’informatique ou de donnée.

Cette situation est très répandue. Le service en question connaît son métier, mais n’a pas forcément conscience de tous les tenants et aboutissants de ses actions à l’échelle de l’entreprise. L’utilisateur n’est donc pas systématiquement attentif à la qualité des informations qu’il transmet, mais bien à la nécessité de remplir la tâche qui lui est attribuée, quels qu’en soient les moyens.

Ainsi, dans leurs activités quotidiennes, les utilisateurs peuvent faire des erreurs, laisser des champs vides, que ce soit volontairement ou non.

Une bonne connaissance du positionnement des utilisateurs dans l’écosystème de l’entreprise est capitale. En utilisant l’analyse de l’existant, la gouvernance des données met en lumière la provenance et la destination des données, du point de vue de l’utilisateur.

La gouvernance joue un rôle essentiel dans la sensibilisation et la responsabilisation du personnel vis-à-vis de la donnée, en élargissant son champ de vision. Son travail est un maillon de la chaîne globale, il a un impact sur d’autres processus et sur l’utilisabilité des données. De la même manière, ils subissent les erreurs survenues en amont.

Les utilisateurs ont été sensibilisés à la qualité de leur saisie, ils ont compris que leur rôle n’était pas limité à l’exécution de leurs tâches, et que leur travail est également à la base de celui d’une partie de leurs collègues.

Inscrire les processus existants dans une démarche globale

Un administrateur de base de données exécute un script afin de corriger des données directement dans la base. S’agit-il d’une action isolée ? Et comment en mesurer les conséquences ?

Il est évident que cette action remplit bien l’objectif à l’instant T qui est de corriger les données afin de respecter les critères d’utilisabilité. Cette action répond probablement à une demande d’un responsable qui a un besoin clairement identifié. Néanmoins, elle est exécutée dans un contexte restreint, et sans transparence. Et il y a fort à parier que dans quelques mois, une situation similaire réapparaîtra.

A minima, la gouvernance intervient dans le cadre d’une réflexion globale. Dans notre exemple, elle va déterminer s’il s’avère nécessaire d’intégrer ce script dans un flux global, avec la documentation et la traçabilité associées.

Mais l’idéal est d’éviter les actions de ce type, car elles relèvent de la correction plutôt que de la prévention.

La gouvernance de données permet d’identifier l’étape du cycle de vie de la donnée où ce défaut de qualité est apparu. Elle suscite ensuite la mise en œuvre en amont des processus qui éviteront cette situation.

Le DBA se consacre désormais pleinement à son domaine d’activité. La connaissance induite par son script est maintenant intégrée dans les processus de traitement qui ont été validés et documentés avec transparence.

L’émergence de nouveaux rôles – Tirer parti de la gouvernance pour assurer la continuité des actions

Le responsable de la facturation se rend compte que la simulation ne concorde pas avec les prévisions. Il doit en urgence identifier les problèmes et trouver des solutions correctives. Il contacte donc les responsables métiers impliqués dans la facturation.

Dans le cadre d’une problématique de qualité de données, les sujets sont pris en charge par les responsables métier afin de convenir de corrections à court terme, en vue de permettre la facturation. Il s’agit d’un objectif isolé avec une seule contrainte.

Or, ce processus entre souvent en collision avec l’activité métier habituelle. De plus, certaines corrections peuvent avoir des impacts sur les traitements métier déjà effectués (réouverture de dossier par exemple).

Grâce aux analyses d’impact et à l’étude des besoins d’utilisation des données, le développement d’une gouvernance aurait fait émerger le besoin de définir des rôles et des responsabilités. Par exemple, celui de data manager (ou data steward) qui a conscience des cas d’utilisation, et qui intervient en cohérence avec des objectifs croisés, identifiés.

Le data manager devient le garant de la qualité de ses données. Il définit des contrôles appliqués au fil de l’eau en prévention, et il s’assure que les critères d’utilisabilité soient respectés.

Depuis la nomination d’un data manager, le responsable de la facturation sait que la qualité des données est assurée. Il a d’ailleurs des tableaux de bord à sa disposition qui rendent le processus de contrôle transparent. Il collabore avec les responsables métiers qui peuvent aisément lisser et organiser les actions correctives. Les impacts des défauts de qualité sont bien mieux maîtrisés, et leurs conséquences anticipées.

La gouvernance garantit une utilisabilité maximale à tous les consommateurs

En matière de consommation de données, il n’existe pas de hiérarchie puisque in fine, quelle que soit la manière de les utiliser, toutes les données serviront à prendre des décisions ou à produire une information.

Or, il est primordial de favoriser une exploitation homogène, via des règles de traitement rationalisées. En s’appuyant sur la gouvernance de données, et en identifiant l’ensemble des destinations, il est possible d’homogénéiser les formats et les règles de traitement. Quand il y a trop de dispersion, la gouvernance ramène la cohérence. Elle peut d’ailleurs s’appuyer sur une architecture distribuée, telle qu’un Data Hub, qui facilite cette démarche.

En donnant plus d’importance au risque de défaut de qualité et plus de cohérence dans son traitement, la gouvernance de données apporte une dimension essentielle dans la gestion de votre actif. Souvenez-vous que la gouvernance de données est une activité métier. N’attendez plus que le service informatique fasse ce travail, il ne relève pas de sa responsabilité. Sa vocation est de supporter la mise en œuvre de processus techniques, pas métier.

En regroupant les métiers dans une démarche qualité commune, vous développez votre capacité à identifier les défauts de qualité et les actions correctives à mettre en œuvre. Vous favorisez donc la collaboration et l’esprit d’appartenance à un groupe cohérent.

Vous disposez maintenant d’un nouveau levier pour mettre en œuvre une gouvernance de données efficace, et donner une dimension plus stratégique à vos actions centrées sur la donnée.

Notre prochain et dernier article vous expliquera comment la gouvernance des données peut favoriser l’émergence d’une « culture data » qui amplifiera tous les bénéfices d’une gouvernance de données efficace.

Talend Day Suisse 2019

Talend Day Suisse, un énorme succès

Mardi 26 novembre 2019 s’est tenu au Mandarin Oriental de Genève le premier Talend Day Suisse.

La Suisse a été mise à l’honneur par notre partenaire Talend avec un événement qui a rassemblé une cinquantaine de personnes.

Après une belle introduction de Jacques Padioleau, Regional VP sales pour la Suisse, la France, La Belgique et le Luxembourg, Christophe Toum, Director of Product Management, a présenté une rétrospective de la Roadmap 2019 et les ambitions pour 2020.

Les Transports Lausannois, à travers Bruno Marie, Responsable domaine SI, a ensuite détaillé leur utilisation des logiciels Talend et du Cloud.

Pour terminer cette matinée, Stéphane Poret, Directeur avant-vente EMEA, a déroulé une démonstration de Talend Cloud afin de montrer comment valoriser un capital Data.

Alors que retenir de cet évènement ?

Talend a mobilisé et déplacé de nombreuses personnes pour un marché Suisse important pour l’éditeur. Nos clients et prospects ont pu échanger sur de nombreux points, sans tabous, avec des personnes de la R&D ou encore du commerce.

Cet événement a été également l’occasion pour nous de mettre en relation certains de nos clients entre eux et de rencontrer des prospects. Il est intéressant de constater qu’un acteur spécialisé comme Synotis trouve facilement son public lors de telles rencontres.

La Roadmap et le produit étant au cœur de ce premier Talend Day Suisse, place à la « technique ».

La tête dans les nuages

La route empruntée par Talend est dans la continuité de ce que l’éditeur nous a présenté ces dernières années et lors du Talend connect 2019 : en route vers du cloud, et encore du cloud. Mais rien d’obligatoire, les versions « On Premise » continuent d’exister et de perdurer. L’équipe Talend présente a bien insisté sur ce point.

Cette transformation est faite de manière pragmatique. Il n’y aura pas de solutions full Cloud ou full « On Premise ». L’avenir est au mode hybride, que ce soit au niveau des produits Talend, ou des sources et des applications que l’on interroge avec Talend. La stratégie est « Cloud First » mais pas « Cloud Only ».

Les intérêts sont divers : Réduction de cout, délégation de l’administration à Talend, élasticité automatique, …

La vision globale : avoir tout un panel de services, d’applications à la manière d’un « app store ».

Le « Pipeline designer », un nouveau jouet

Cet outil est un savant mélange entre un studio (Job Designer / Route designer) et de la Data Preparation.

L’idée : permettre de développer des flux, pour le moment simples, à partir de différents datasets et en appliquant différentes transformations (agrégation, formatage, etc), des liaisons entre ces sources, et d’avoir un flux de sortie.

Outre le design et le choix des différentes règles/fonctions, une visualisation on-live de l’évolution des données au fil du traitement est disponible, facilitant le développement et les paramétrages.

N’hésitez pas à nous solliciter si vous souhaiter en savoir plus : contact@synotis.ch

Talend Connect 2019, vu de Suisse …

Déjà 2 semaines. Le 17 octobre 2019 s’est tenu le 7ème Talend Connect de l’histoire de Talend. C’est un événement majeur de ce mois d’Octobre, dont nous allons vous résumer ici les moments forts.

Tout d’abord, le Talend Connect Paris, c’est le grand événement annuel organisé par l’éditeur pour sa communauté, ses clients francophones et ses partenaires.

Des clients viennent témoigner de leurs expériences de l’utilisation de leurs logiciels, Laurent Bride (CIO et COO de Talend), nous parle de stratégie et Christophe Toum (Director of Product Management de Talend) nous parle de Road Map.

Nous avons toujours plaisir à y participer car nous y revoyons beaucoup de monde chez Talend mais également des clients/prospects. Cette année, étaient notamment présentes des personnes de l’ECA, des Transports Publics de la Région Lausannoise, de la Romande Energie et de Jaeger-LeCoultre.

Commençons par le début, cette année Talend Connect s’est tenu au Parc des Princes. Que nous soyons fans du Paris Saint-Germain ou non, le lieu ne laisse pas indifférent tant par sa grandeur que par l’aura qui s’en dégage.

Nous ne savons pas si le lieu y a joué un rôle mais la fréquentation à l’événement a battu des records. La Keynote, la Road Map et le retour d’expérience du Groupe Accor avec leur partenaire Snowflake ont fait salle comble.

Parlons d’ailleurs de cette Keynote, présentée par Laurent Bride.

Dans un monde en pleine mutation, les organisations doivent sans cesse s’adapter et évoluer. Dans ce contexte, le Cloud s’affiche comme un élément clé de la transformation des entreprises. Vous l’aurez compris, la stratégie de Talend est complètement tournée vers le Cloud. Afin de répondre à des besoins d’intégration sans cesse grandissants, la « scalabilité » des solutions est devenue cruciale pour traiter des volumes de données importants dans des délais courts. On notera par ailleurs que Talend repose sur AWS et Azure, ce second acteur pouvant être particulièrement intéressant pour le marché helvétique (https://www.ictjournal.ch/news/2019-08-28/microsoft-ouvre-son-cloud-suisse)

Mais rassurez vous, les solutions « On Premise » de Talend vont continuer à évoluer.

La Road Map

Parlons maintenant de la Road Map, présentée par Christophe Toum, Director of Product Management de Talend.

Présentons sans tarder Talend Data Fabric. C’est une plate-forme complète permettant de collecter, gouverner, transformer et partager l’ensemble des informations des entreprises. Cette plateforme est disponible On Premises, en multi-cloud ou en mode Hybrid. Elle permet aux clients de Talend de transformer de la donnée brute en donnée utile pour l’entreprise. La data est considérée de nos jours comme le nouvel Or noir, qu’il faut donc apprendre à raffiner.

En 2019, Talend s’est concentré sur 4 éléments :

- Stitch Data Loader, solution de Data Ingestion intuitive dans le Cloud, entièrement managée pour démarrer vos processes analytiques rapidement

- Talend Pipeline Designer : solution permettant d’ingérer de la donnée structurée et non structurée en Batch ou en Streaming

- Talend Cloud dans Azure : pour les modules Data Intégration, Data Quality et Integration Big Data

- Talend Data Inventory : permet de faire du Trust Score automatiquement agrégé sur une source à partir d’informations de Data Quality, de tags de certification, d’un rating utilisateurs et de la popularité.

Qu’est ce qui nous attend pour 2020 ?

Talend ambitionne de proposer la Data Fabric la plus avancée du marché.

Pour cela les efforts vont être réalisés sur les éléments suivants :

- Orchestration avancée : orchestration basée dans le Cloud, ouverte et extensible

- Pipelines avec SQL push-down : performance des pipelines avec les données co-logées en base de données

- DQ rules : définition et application de règles de Data Quality pour toute la plate-forme

- API Creator : pour passer du Dataset à une API en quelques clics.

En plus de tout cela, la plate-forme va devenir intelligente avec l’utilisation de l’Intelligence Artificielle pour le Design, les opérations et la Data.

Les objectifs sont de développer l’auto-apprentissage pour accélérer le design et identifier facilement les mauvaises pratiques pour les corriger, détecter automatiquement les changements de comportement à l’exécution afin de mieux prévenir les anomalies et identifier automatiquement les changements de pattern des Data pour détecter automatiquement les dérives.

Cette vue macro de la Road Map n’est évidemment pas exhaustive.

Si vous souhaitez avoir des précisions sur certains points, nous trouverons certainement les bons points d’entrée chez Talend pour vous restituer l’information que nous aurons l’autorisation de vous transmettre.

Ateliers techniques et métiers

L’après-midi fait place à deux types d’interactions : des retours clients d’une part et des ateliers techniques de l’autre.

Concernant la partie technique, la digestion n’attend pas et on démarre directement l’atelier “Votre nouvelle plateforme de données cloud”. On y découvre un cas d’usage de mise en place d’une plateforme Cloud Talend ainsi que les bonnes pratiques associées. La séance est animée, les retours d’expérience de l’assistance validés par un bracelet allumé en bleu en vert selon la réponse souhaitée. Un moyen efficace de procéder à un sondage dans une salle pleine. Un petit côté “Landsgemeinde des temps modernes”.

Sera présenté La puissance de Talend Cloud et du Pipeline Designer. On doit bien avouer que l’aisance de la part de l’animateur a de quoi faire pâlir un studio “Standard”. On y retrouve les éléments visuels de la Talend Data Stewardship et l’interface de Talend Data Preparation.

On enchaîne sur un atelier brassage de bière! Enfin, c’est ce que l’on croit dans un premier temps, mais derrière le Use Case léger , c’est du sérieux. Il s’agit d’un site Web de références de bières avec toutes les caractéristiques associées (type de bière, niveau d’amertume, couleur, degré d’alcool, etc) et qui propose un classement personnalisé des meilleures bières. Comment ? Grâce à des algorithmes de Machine Learning évidemment !

On y découvre une présentation de bout en bout, utilisant des briques qui font la force de l’architecture Talend , nouvelle et ancienne génération : des flux d’ingestion de la donnée (via le Pipeline, mais aussi possible avec Talend Data Integration ou Mediation), des traitements de qualité de données; les doublons sont envoyés en console de Stewardship. On remarque au passage que la qualité des données est cruciale dans les traitements en général, de Machine Learning en particulier dans ce cas-ci, car il est démontré que des données de mauvaise qualité entraînent une modification du classement final proposé à l’utilisateur. Une bière blanche ou une ambrée, c’est pas les mêmes saveurs ! L’intégration avec Azure se fait de manière aisée, les briques s’assemblent comme il se faut et on bénéficie de la puissance des technologies Cloud.

Le dernier atelier portait sur “L’optimisation des processus DevOps”.

Malheureusement, nous entamions déjà notre retour en train direction les rives du Léman…

En synthèse, cette année fut un grand cru. Le lieu, l’organisation, la qualité des Keynotes, la qualité des intervenants clients, les uses cases présentés et la présence nombreuse des clients/prospects Talend ont largement contribué au succès de cette édition 2019.

Nous remercions toutes les personnes qui ont contribué à faire de cet événement un moment exceptionnel. Spéciale dédicace au marketing pour cette organisation “quasi” Suisse.

Si vous souhaitez revoir les Keynotes, n’hésitez pas à visiter ce lien

Séminaire d’entreprise Synotis – Zermatt 2019

Zermatt 2019 – jour 1 : un peu de travail et beaucoup de rigolade

Après de nombreux échanges afin de nous mettre d’accord sur le lieu et sur les activités, un consensus fut trouvé et notre séminaire d’entreprise annuel nous a mené à Zermatt. Station de ski suisse emblématique, cette destination est tout autant appréciée l’été. C’est donc avec impatience que l’ensemble de l’équipe Synotis attendait le jour J pour se rend dans ce havre de paix montagnard.

Après de nombreux échanges afin de nous mettre d’accord sur le lieu et sur les activités, un consensus fut trouvé et notre séminaire d’entreprise annuel nous a mené à Zermatt. Station de ski suisse emblématique, cette destination est tout autant appréciée l’été. C’est donc avec impatience que l’ensemble de l’équipe Synotis attendait le jour J pour se rend dans ce havre de paix montagnard.

Après un joli voyage en train, les affaires déposées dans nos chambres et un copieux petit déjeuner, nous nous sommes attelés à la tâche.

La matinée fut riche en échanges et en discussions autour du thème de la Data. Un brainstorming en équipe est toujours un moment apprécié par tous.

Pour clore ce premier épisode, un repas nous attendait, mêlant sans distinction chacune des équipes de consultants et nous permettant d’échanger sur des sujets divers et variés. Un bon moment de convivialité, important pour la cohésion d’équipe quand on sait que le reste de l’année, nous sommes chez nos clients respectifs.

Après une nouvelle séance de brainstorming, courte, nous nous sommes mis en route vers le Gornergrat, situé à plus de 3000 m d’altitude pour y faire un apéro en altitude. Quelle vue magnifique sur le Cervin (Matterhorn en Allemand). Les verres s’enchaînent, et les esclaffades aussi ! Malgré l’altitude, personne n’a été malade.

Le temps de prendre quelques belles photos et nous prirent le chemin de la redescente sur Zermatt où nous attendait une soirée riche en émotion dont nous garderons les images secrète (à bon entendeur).

Ce qui se passe à Zermatt reste à Zermatt.

Zermatt 2019 – J 2 : Sous le signe de l’effort.

Après avoir été consultée, les équipes Synotis ont opté pour une montée en E-Bike (VTT électrique) vers le Sunnegga. Après une soirée éprouvante, nous poursuivons donc notre séminaire sous le signe de l’effort.

Après avoir été consultée, les équipes Synotis ont opté pour une montée en E-Bike (VTT électrique) vers le Sunnegga. Après une soirée éprouvante, nous poursuivons donc notre séminaire sous le signe de l’effort.

Au programme une ascension de 900m de dénivelé positif qui aura duré 1h30. Pour la plupart d’entre nous, cette discipline fut une découverte et, pour certains, une révélation. La pratiquer dans ce cadre idyllique a finalement eu comme conséquence de reposer les esprits à défaut des organismes. A l’arrivée, un repas bien mérité au Adler accompagné d’une vue imprenable sur tout le Cervin.

Il est déjà 14h, il est temps pour nous d’aborder la partie la plus plaisante, la descente ! C’est énergique et fort en sensation, une heure de descente en VTT jusqu’à Zermatt.

Petite anecdote, un membre de l’équipe a crevé le pneu arrière après 500 m de descente. Son aventure s’est terminée à pied pour son plus grand désespoir. L’heure est désormais à la dispersion pour reprendre le chemin vers un week-end plus paisible en famille.

C’est ainsi que s’achève ce merveilleux week-end de séminaire 2019.

Nous avons testé : Tableau’s New Data Model

New Data Model Tableau (Pre-Release)

Tableau avait annoncé le déploiement d’une nouvelle interface de gestion des sources de données sur Tableau desktop lors de la TC18. Ce « New Data Model » est désormais au stade de Pre release, mais cette innovation est à mon sens très prometteuse.

Les nouvelles capacités de modélisation de données augmenteront principalement les capacités et la simplicité d’analyse, ainsi que les performances, et faciliteront la maintenance. Ce « New Data Model » permettra également de réduire sensiblement le nombre de sources nécessaires à une organisation. Trop beau pour être vrai ?! C’est ce que nous avons testé.

Le système de modélisation de sources de donnée actuellement en place (2019.2) transforme les jointures entre les différentes tables en une seule table à plat. Ce mode de fonctionnement engendre une duplication des données et peut potentiellement induire une baisse de performance. C’est ainsi que naissent les problématiques standards de niveau de détail (LOD).

Le « New data model Tableau» devrait nous permettre de définir des relations entre tables à différents niveaux de détail dans une seule source de données. Les relations seront donc dynamiques par rapport au contexte de la vue.

Cette nouveauté implique la disparition de la définition des types de relation (iner, left, right, full). Ils sont automatiquement attribués en fonction des champs utilisés dans la vue. Et qui dis moins de jointures, parle automatiquement d’amélioration des performances !

Cette innovation est sans nul doute un changement fondamental dans la façon dont Tableau génère des requêtes. Cela devrait impacter assez fortement les développements (futurs, et passés) sur Tableau.

Si vous souhaitez effectuer vos propres tests, vous pouvez télécharger la Pre-release ci-dessous, pour les plus pragmatiques, vous pouvez vous en remettre à notre test !

Simplifier le processus de modélisation des données

Tableau peut s’appuyer sur votre schéma de base de données en étoile ou en flocons existants afin de créer automatiquement des relations dans vos données, ce qui vous permet d’accéder à la phase d’analyse plus rapidement et sans avoir besoin de connaissance du modèle de la BDD.

Une expérience d’analyse plus intuitive

Coupez et découpez des données plus complexes en toute confiance, car Tableau comprend et gère le niveau de détail de vos données, en tenant compte automatiquement de nombreux scénarios de duplication de données et en vous assurant d’obtenir des résultats précis sans avoir à effectuer de calculs LOD.

Cette contrainte pouvait être difficile à appréhender pour un utilisateur métier faisant des analyses ad hoc. Cela avait comme potentielle incidence d’entrainer de la confusion et un rejet de l’outil.

Grâce au nouveau modèle de données, cette contrainte n’existe plus. Tableau ajuste automatiquement sont niveau de calcul en fonction de la vue. Les tests que nous avons effectués ont été concluants (voir vidéo).

Sources de données plus performantes

Grâce à cette nouvelle fonctionnalité, Tableau requêtera désormais uniquement les tables utilisées dans le tableau de bord. Vu qu’il y aura moins de jointures et de calculs, nous aboutirons à une nette amélioration des performances.

Moins de sources de données à maintenir

Les sources de données utilisables par tableau pouvant être désormais plus génériques et complexes, elles peuvent donc répondre à une plus grande variété de questions. De ce fait, les organisations seront en mesure de réduire le nombre de sources de données distinctes qu’elles créent et gèrent.

Notre Test :

Nous avons choisi de tester la promesse la plus sexy de ce nouveau data modèle : la génération de requête contextuelle en fonction de la vue.

Pour ce faire, nous nous sommes servis du dataset « Exemple-Hypermarché » que nous avons modifié en créant une colonne year(date de commande) pour effectuer la liaison dans la Pre-release et d’un dataset complémentaire traitant des budgets par année, pays et catégorie de produit.

Vous pourrez refaire ce test vous-même en installant la Pre-release Tableau (Windows & OSX) et l’exemple disponible en téléchargement ci-dessous.

Découvrez notre test en live avec cette petite vidéo.

Conclusion

Nous rappelons que nous traitons dans cet article d’une Pre-realease et qu’il faut rester attentif à la finalisation du développement de ce feature. Nous allons suivre l’évolution et nous ne manquerons pas de vous tenir au courant de l’avancement.

visionner